L’integrazione tra intelligenza artificiale generativa e architetture a microservizi è oggi uno dei campi più dinamici dell’ICT. In particolare nel mondo .NET, dove strumenti evoluti, containerizzazione e CI/CD si incontrano con modelli AI come GPT, Claude, Gemini per dare vita a servizi intelligenti e scalabili.

Ma come si progetta un’architettura che permette a un servizio AI di lavorare con decine di microservizi, orchestrati e distribuiti? E quali sono i casi d’uso reali?

Un nuovo layer nella tua architettura

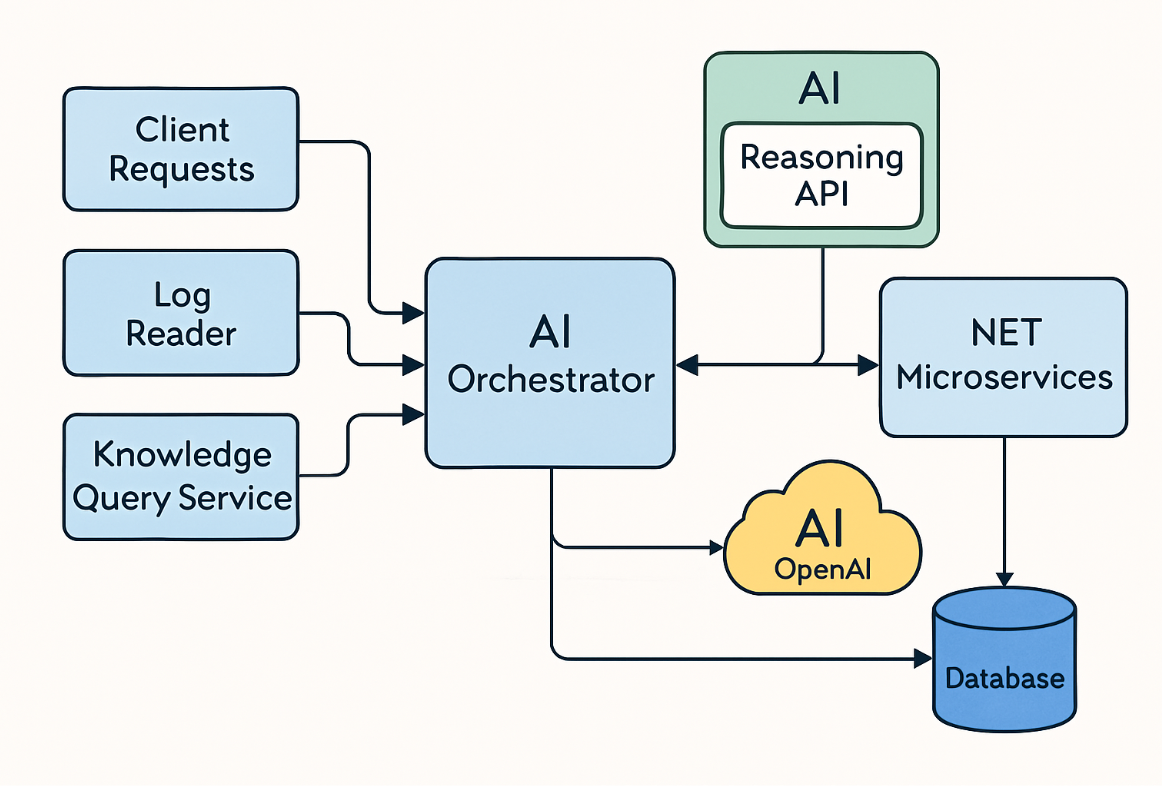

Non parliamo più solo di API REST o di servizi CRUD. Quando entra in gioco un modello linguistico (LLM), si aggiunge un nuovo livello: quello della reasoning API, ovvero un microservizio dedicato all’interazione con l’AI.

Questo servizio riceve richieste strutturate (o semistrutturate), genera prompt, li invia al modello e restituisce risposte arricchite. Può essere stateless, oppure memorizzare contesto e logica conversazionale per sessioni utente complesse.

Nel mondo .NET, questo si realizza con una Web API ASP.NET Core, containerizzata in Docker, orchestrata con strumenti come Kubernetes, MassTransit, Azure Service Bus, RabbitMQ o Dapr.

Architettura in azione: uno scenario concreto

Immagina una suite di microservizi per la gestione di richieste da parte di clienti (ticketing, knowledge base, log di sistema, notifiche). A un certo punto, il cliente pone una domanda non strutturata:

“Ho ricevuto un errore strano nel caricamento file, che posso fare?”

Il sistema attiva il microservizio AIOrchestrator, che costruisce un prompt dinamico basato su:

- log recenti (raccolti da un servizio

LogReader) - contenuti KB (recuperati da

KnowledgeQueryService) - policy di sicurezza e compliance (via

SecurityLayerService)

Il prompt viene inviato a Azure OpenAI o OpenAI API tramite un client specializzato sviluppato in C#. La risposta viene validata, arricchita da un servizio di formattazione, e inviata come notifica al frontend, oltre che loggata nel data lake.

Orchestrazione intelligente

La vera sfida non è chiamare l’AI, ma orchestrare i flussi. I servizi .NET dialogano tra loro tramite messaggistica asincrona, queue, eventi. Un cambiamento in un database può attivare un processo AI automatico per:

- classificare incidenti

- redigere sintesi di eventi complessi

- precompilare report o e-mail

- valutare anomalie nei dati (es. log o transazioni)

Tecnologie chiave:

MassTransit, Azure Functions, MediatR, Polly, Hangfire, gRPC per ottimizzare le performance tra servizi distribuiti.

Prompt dinamici e sicurezza

Un prompt costruito da codice è molto diverso da uno scritto a mano. Serve attenzione nella costruzione dei messaggi, evitando injection, prompt leakage, ambiguità.

In molti scenari .NET, si usa un template engine (Razor, StringBuilder, Scriban) per costruire prompt con dati runtime, identificatori univoci, contesto utente. Tutto deve passare da filtri e validazioni, perché l’AI non è deterministica, e va trattata come un componente “non affidabile”.

Casi d’uso in crescita

Tra i casi d’uso più richiesti in azienda troviamo:

- AI per il supporto tecnico (ITSM con AI generativa)

- Generazione di documentazione automatica (a partire da dati o metadati)

- Classificazione semantica di messaggi o log

- Analisi del sentiment in feedback o comunicazioni interne

- Assistenza alla redazione di mail, policy, contratti

Conclusione: un’AI distribuita, ma sotto controllo

Integrare AI nei microservizi .NET è tecnicamente possibile e sempre più strategico. Richiede attenzione su performance, monitoraggio, costo per token e governance.

Ma è anche un’opportunità unica per portare intelligenza distribuita in ambienti enterprise, senza stravolgere l’architettura esistente.

Chi saprà orchestrare bene questi flussi, progettare prompt sicuri e sfruttare il meglio dell’ecosistema .NET, sarà il motore di innovazione nei prossimi anni.

Fonti ufficiali

Riproduzione riservata © Copyright Echo Pox